A pesar de los riesgos potenciales de los ataques DDOS y otras amenazas de seguridad, muchos editores no reconocen el problema y hacen la vista gorda ante el tráfico de bots, ansiosos por hacer que los números de tráfico sean más atractivos. En realidad, la ausencia de una gestión de bots eficaz puede poner en riesgo todo el proyecto, perjudicar la experiencia del usuario o alejar a los anunciantes del inventario del sitio.

En pocas palabras, los bots representan aplicaciones que realizan tareas repetitivas automatizadas a escala, como la clasificación de páginas web con fines de SEO, la agregación de contenido o la extracción de información. Los bots a menudo se distribuyen a través de una botnet, es decir, copias conectadas del software del bot que se ejecutan en varias máquinas con diferentes direcciones IP. Desde la perspectiva del propietario del sitio web, los bots pueden ser buenos, malos o irrelevantes. Averigüemos qué hacen en su sitio web y cómo usted puede controlar la situación.

Bots buenos y cómo permitirlos

Los bots buenos están diseñados para completar misiones alineadas con los objetivos de los editores. Uno de los tipos más comunes son los bots araña, que los motores de búsqueda o los servicios en línea utilizan para descubrir su contenido, clasificar las páginas y hacer que su sitio web esté disponible a través de los resultados de búsqueda. Otro ejemplo son los bots de comparación, que ayudan a los usuarios a encontrar sus productos u ofertas a través de servicios de comparación de precios. Finalmente, los bots de datos tienen como objetivo agregar contenido sobre un tema en particular o proporcionar actualizaciones sobre nuevas publicaciones, pronósticos meteorológicos, tipos de cambio, etc.

Puede administrar los bots buenos utilizando un archivo robots.txt que usted debe colocar en su directorio de home. Al realizar los cambios necesarios en este archivo, puede incluir en la lista blanca las arañas que le interesan o especificar las páginas exactas que desea que rastreen.

Para evitar una medición de audiencia sesgada, puede excluir todas las visitas de bots buenos en Google Analytics. También puede configurar la lista específica de direcciones IP para ignorar arañas y otros bots buenos con fuentes conocidas en los informes de análisis.

Algunos bots buenos también pueden ser irrelevantes para sus objetivos comerciales. Por ejemplo, ciertos bots pueden rastrear su sitio web en busca de categorías de contenido no relacionadas con su proyecto. También es posible que desee mantener alejados a estos bots irrelevantes bloqueándolos por sus direcciones IP o excluyéndolos de la lista de bots permitidos.

Evite el tráfico de bots maliciosos y los ataques de bots

Los bots maliciosos tienen como objetivo causar daños a su sitio web y pueden venir en una variedad de tipos. Quizás, los más dañinos están enmascarados como visitantes humanos y evitan los sistemas de seguridad del sitio web para hacer que el sitio se caiga. Los bots impostores se disfrazan de bots buenos y extraen contenido web para publicarlo en otros sitios, recolectan las credenciales o direcciones de correo electrónico de los usuarios, violan los términos de servicio de un sitio web o realizan otras acciones maliciosas. A partir de un estudio del año pasado, se sabe que más de la mitad de los bots malos afirman ser Google Chrome. Los bots fraudulentos, por otro lado, operan bajo el radar e intentan robar tal información como datos personales, información de tarjetas de crédito, etc., o incluso piratear servidores de datos.

Ejemplos comunes de bots maliciosos son los ataques DOS y DDOS. Un ataque de denegación de servicio (DOS) utiliza una sola máquina que tiene como objetivo la vulnerabilidad del sitio web o envía una gran cantidad de paquetes o solicitudes. Sin embargo, un ataque DDOS involucra varias máquinas o botnets conectados con los mismos fines. El resultado de estos ataques de bots es que el recurso objetivo se agota por servir a los usuarios previstos. Muy a menudo, los ataques DDOS se ejecutan para que los propietarios de empresas paguen un rescate por su infraestructura; estos bots se denominan ransomware.

En algunos casos, una alta tasa de rebote y un número extraordinario de páginas vistas pueden indicar la persistencia continua de robots malos, ya que el comportamiento humano suele producir un rebote más bajo. De manera más general, para detectar el tráfico de bots maliciosos, debe observar todas las solicitudes de red que recibe el sitio web y analizar los archivos de registro para tratar de identificar solicitudes sospechosas, comportamientos poco probables o anomalías. Por ejemplo, puede detectar un aumento en el tráfico de una región inusual, una duración de sesión inferior a la habitual, etc.

Por supuesto, la detección no evita los ataques. Una vez que se detectan las vulnerabilidades de un sitio web y la huella de bots maliciosos, debe emplear otras herramientas y mecanismos para bloquearlos. Dependiendo de la lógica comercial de su sitio, puede proteger las API expuestas, agregar CAPTCHA en algunos puntos, limitar el tráfico de red por IP o ubicación, poner un límite a la frecuencia con la que un visitante puede enviar solicitudes, etc.

Para grandes proyectos web, es necesario implementar un sistema de gestión de bots que permita la diferenciación granular del tráfico de bots. Algunas soluciones populares de gestión de bots son, por nombrar algunas, Cloudflare, ClickGUARD, Radware y Akamai.

Impacto en la publicidad

Los bots pueden causar una pérdida significativa de los presupuestos de marketing y sesgar los datos de las campañas. Además, algunas botnets basados en la nube pueden generar impresiones publicitarias o clics falsos, lo que se conoce como fraude de clics. Para mantener la confianza en el ecosistema publicitario, los editores deben proporcionar datos precisos sobre su audiencia y bloquear las actividades de fraude de clics en sus sitios. Por el momento, si monetiza un sitio web a través de anuncios y hay algún tipo de fraude de clics o datos de tráfico significativamente inflados, todos los principales proveedores de anuncios están obligados a prohibir el sitio en la red.

En MGID, estamos orgullosos de ser reconocidos por ser capaces de detectar tráfico de bots y fraudes publicitarios. En 2020, MGID recibió el sello TAG Certified Against Fraud Seal por su solución patentada de protección contra el fraude. También utilizamos la herramienta de detección de fraudes de Anura para garantizar la calidad del tráfico. Además, contamos con un equipo interno de análisis que verifica manualmente el tráfico de forma periódica.

Pensamiento final

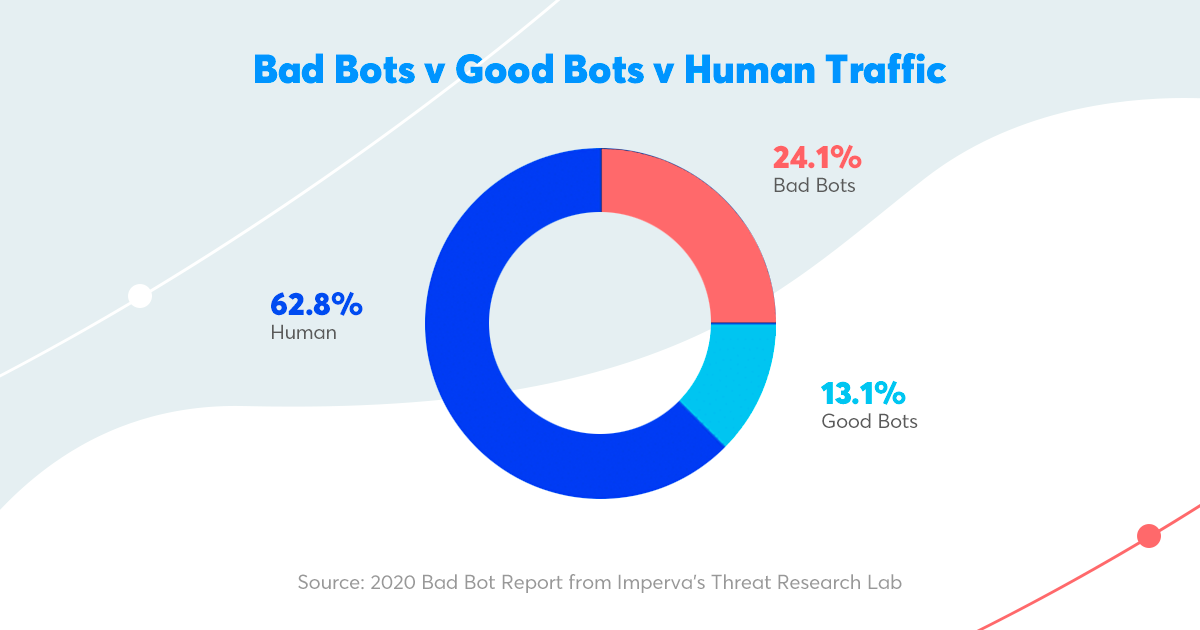

Hoy en día, alrededor del 40% del tráfico de Internet es tráfico de bots, y los bots maliciosos son probablemente uno de los mayores dolores de cabeza para muchos editores. Para proteger su sitio del tráfico de bots no deseado, le recomendamos que utilice una de las soluciones modernas de administración de bots, como Cloudflare, ClickGUARD, Radware o Akamai. También puede controlar los bots buenos, como las arañas o rastreadores, cambiando la configuración en el archivo "robots.txt".